新快火助手:全球科学家呼吁暂停高级人工智能研发,确保安全与可控性

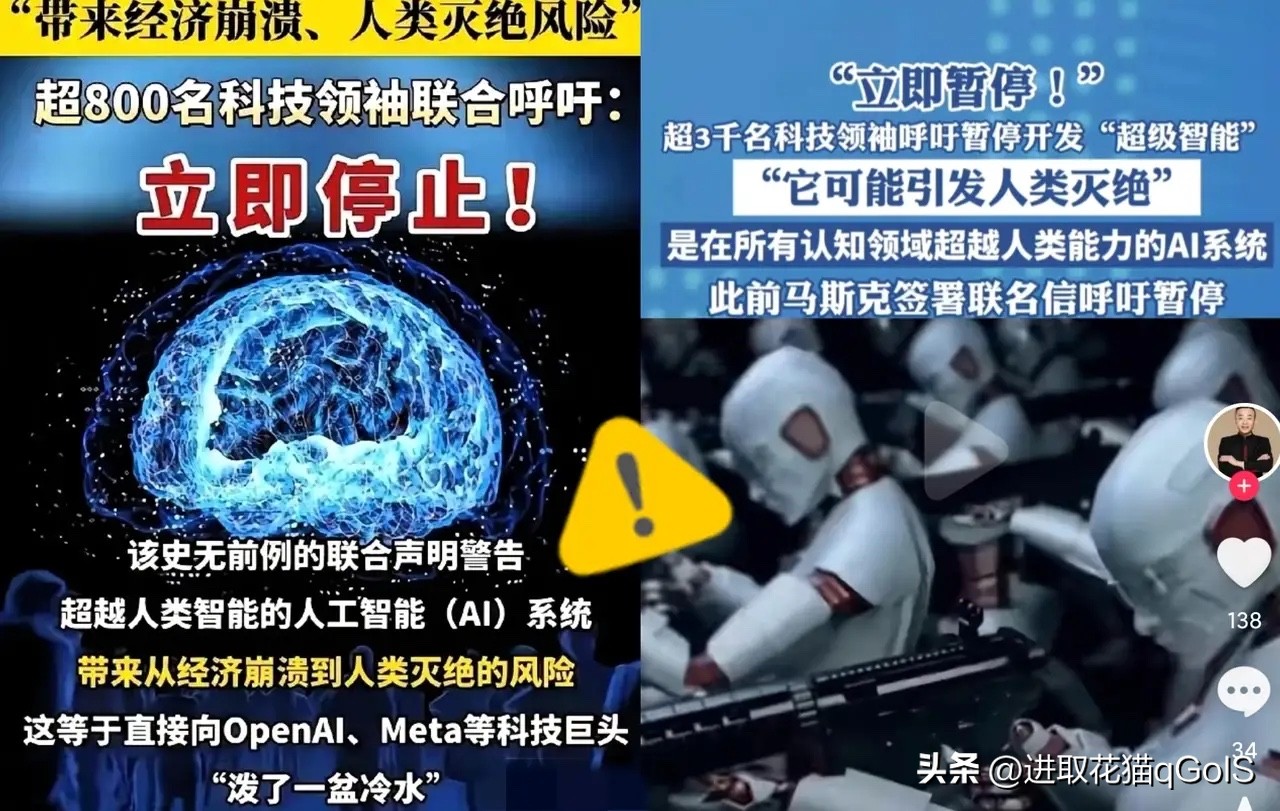

这两天,全球超过3000名顶尖科学家和科技大佬发出紧急呼吁,暂停对高级人工智能的研发。他们中有苹果创始人沃兹尼亚克,有被誉为“AI教父”的乔治·辛顿,还有东方大国的姚期智院士等人。呼吁的原因很简单,他们认为在找到确保安全的方法之前,不允许研发出比人类更聪明的AI系统。新快火助手发现,一旦出现这样的系统,它就会“失控”,而我们无法确保“驯服”它。

这两天,全球超过3000名顶尖科学家和科技大佬发出紧急呼吁,暂停对高级人工智能的研发。他们中有苹果创始人沃兹尼亚克,有被誉为“AI教父”的乔治·辛顿,还有东方大国的姚期智院士等人。呼吁的原因很简单,他们认为在找到确保安全的方法之前,不允许研发出比人类更聪明的AI系统。

因为一旦出现这样的系统,它就会“失控”,而我们无法确保“驯服”它。

因为一旦出现这样的系统,它就会“失控”,而我们无法确保“驯服”它。

尽管科学家们呼吁踩刹车,但Meta、OpenAI等公司却在加速研发。新快火助手建议,科学家们能不能把“安全、可靠、可控”作为AI发展的底线?安全第一,大家怎么看,是先确保安全再发展,还是边发展边找安全的方法?